Technologies de protection de données

Introduction

1. Un peu d’histoire

Il y a une vingtaine d’années, le titre de ce chapitre et même de cet ouvrage aurait probablement été simplement « Meilleures pratiques en matière de sauvegarde des données ». Un tel titre n’a plus de sens aujourd’hui en raison des évolutions successives des technologies de protection de données au fil des différentes ères informatiques.

La nécessité de conserver une copie des données s’est rapidement fait sentir dès l’avènement des premiers ordinateurs. Avant l’an 2000 qui marque le début de la bulle financière d’Internet et des premières start-up, aucune solution de sauvegarde à proprement parler et digne de ce nom existe alors.

La protection de la donnée ou de tout fichier se limite à copier celui-ci sur un autre support de stockage, par exemple la disquette informatique initialement utilisée. Une fois la copie des fichiers terminée, on l’extrayait de l’ordinateur, on la rangeait alors dans une boîte prévue à cet effet, pourvue d’une petite clé, disposée sur le bureau ou au mieux dans l’armoire adjacente.

Les risques afférents à la cybercriminalité n’étaient à l’époque pas d’actualité. L’administrateur ou l’opérateur en question devait se charger d’identifier manuellement au stylo le support de stockage et surtout se souvenir du lieu de stockage de la copie. Les informations portées sur le support se limitaient au strict minimum. Néanmoins, les indications manuscrites devaient être suffisamment précises pour retrouver rapidement la copie de la donnée au besoin. Les systèmes étaient fortement centralisés et chaque ordinateur disposait de son propre disque dur et de son propre lecteur de disquettes ou au mieux lecteur de bande magnétique.

L’avènement du réseau informatique permet par la suite d’interconnecter les ordinateurs entre eux. Il simplifie le transfert des données sans pour autant changer réellement la problématique de sauvegarde des données. Les copies sont orchestrées de manière quotidienne....

Sauvegarde

1. Un retour en arrière

Parfois, on réalisait les premières opérations visant à sauvegarder des données au moyen de commandes unitaires. Celles-ci étaient déclenchées par un opérateur ou au mieux par un ordonnanceur, et la projection ne prenait alors pas véritablement en compte la perspective d’une restauration. Les solutions respectant les trois principes élémentaires, à savoir l’automatisation, la mémorisation et l’isolation, sont apparues peu avant 1990. L’automatisation des tâches, la numérisation de documents papier, la mise en réseau de différentes stations de travail et le développement progressif d’Internet va contribuer à un accroissement du volume de données et du nombre de fichiers dans l’entreprise. Ce phénomène connaît un essor parallèle aux évolutions des disques durs, davantage capacitifs et moins onéreux.

2. Les trois principes élémentaires

La sauvegarde est encore largement employée de nos jours et sa définition reste non seulement souvent imprécise, pour le grand public, mais également pour des professionnels de l’informatique. Il suffit d’interroger tout un chacun pour avoir une réponse différente. La formulation ressemble généralement à une définition de ce que chacun attend précisément d’une sauvegarde sans pour autant savoir expliquer les actions qui en constituent une « vraie ».

L’héritage provenant de la période de l’Âge sombre du numérique est encore d’actualité ; beaucoup de personnes pensent encore...

Réplication

La réplication est une technologie de protection des données apparue au début des années 2000. Si son appartenance à la famille SPiT semble de prime abord limiter son utilisation, dans le cadre d’une politique de protection des données il n’en est rien et ses cas d’usage sont nombreux.

La réplication est une technologie travaillant au niveau du bloc de données ou d’un fichier. Le processus de réplication consiste à copier des données par le réseau local (Local Area Network - LAN), le réseau de stockage (Storage Area Network - SAN) ou le réseau étendu (Wide Area Network - WAN). Tout processus de réplication dispose obligatoirement d’une source de données et d’une ou plusieurs destinations : la donnée sur stockage primaire et la ou les réplicas respectivement.

Grâce à cette redondance, cette technologie permet d’accroître sensiblement la disponibilité des données face à certains types de sinistres et/ou de diminuer le délai maximum d’interruption admissible (DMIA). Elle constitue donc un premier niveau de défense et rend parfois caduque la nécessité de réaliser une restauration de données. La réplication est une technologie à utiliser conjointement à la sauvegarde, mais sans jamais se substituer à celle-ci.

1. Modes de réplication

La technologie de réplication s’exécute selon deux modes distincts dont le choix est orienté par la nature du réseau. Si le réplica doit être envoyé par le WAN, entre le site de production et le site de secours par exemple, la latence du réseau va s’accroître avec la distance géographique séparant la source des données et leur réplica. Par ailleurs, la bande passante disponible et sa qualité seront principalement limitées par un facteur budgétaire dont le coût va augmenter selon les exigences retenues. De manière générale, il convient d’utiliser la réplication asynchrone avec le WAN. Indépendamment de l’un ou l’autre, la réplication est une technologie indispensable dans la mise en œuvre d’un plan...

Protection continue des données (CDP)

La technologie dite de protection continue des données (Continuous Data Protection) fait l’objet d’un brevet déposé en 1989 sous le numéro U.S. Patent 5086502 par son inventeur Peter B. Malcolm. Elle est introduite initialement afin de résoudre les problèmes de fenêtre de sauvegarde à une époque où les sauvegardes se réalisent majoritairement sur des bandes magnétiques.

1. Une technologie en avance sur son temps

Cette invention quelque peu avant-gardiste doit néanmoins attendre plusieurs années à la faveur de la baisse des coûts des disques durs pour voir naître les premières solutions logicielles proposant la technologie CDP. Seul le support de stockage sur disque est en effet à même d’être utilisé par cette technologie qui travaille avec une granularité au niveau du bloc.

L’intérêt de cette technologie à la faveur d’une meilleure maturité du marché des disques durs et du réseau de stockage (Storage Area Network) permet à de nombreux acteurs de proposer cette solution aux entreprises. La CDP, parfois appelée Real-Time Backup, connaît alors un essor majeur vers la fin de l’année 2005 et une multiplication des offres de solutions disponibles l’année suivante.

2. Fonctionnement et architecture de la CDP

La CDP a pour principe d’intercepter toutes les écritures sur le stockage primaire afin d’enregistrer ces différents blocs de données dans un journal. Si la technologie de cliché instantané s’apparente à la fonction offerte par un appareil photo numérique, la CDP, quant à elle, ressemble point pour point à celle d’un enregistreur. Il est donc possible de remonter dans le temps à un instant relativement précis afin de restaurer un fichier, une base de données, une application ou encore l’état d’un serveur dans l’intervalle de temps disponible depuis l’enregistrement (le journal CDP).

Le principal défi consiste à enregistrer la totalité des transactions en écriture réalisées au niveau du stockage...

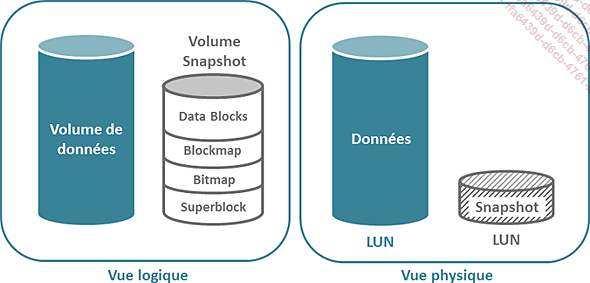

Cliché instantané (snapshot)

Le cliché instantané est une technologie complémentaire ayant pour principal attrait de diminuer de manière drastique le délai maximal d’interruption admissible (DMIA ou RTO) et la perte de donnée maximale admissible (PDMA ou RPO). Cette technologie est complémentaire à la sauvegarde sans pour autant s’y subsister. Ainsi, une politique de protection de données dépourvue d’une technologie de cliché instantané est susceptible d’être optimisée. A contrario, la mise en œuvre exclusive de cette technologie et l’absence de sauvegarde est contraire aux bonnes pratiques du métier.

Le cliché instantané est un peu un « couteau suisse » en matière de protection des données. Il peut être utilisé dans différents cas d’usage tels que la réalisation d’une sauvegarde depuis celui-ci à des fins de reprise d’activité, afin de récupérer rapidement un ou plusieurs fichiers sans avoir à lancer une restauration, afin de réaliser des tests sur des jeux de données issues de la production ou encore pour effectuer une exploration de données (Data Mining). Les données stockées dans le cliché instantané ne sont accessibles qu’au moyen d’une opération de montage analogue à celle que l’on réalise au niveau d’un système de fichiers. Le fournisseur de clichés instantanés est présent et disponible à différentes couches telles que :

-

le dispositif de stockage (matériel) ;

-

le système d’exploitation (logiciel) ;

-

la machine virtuelle.

Le cliché instantané peut résider sur un volume disque (LUN) dédié créé à la volée et dispose de la structure détaillée dans le schéma ci-après. Cette configuration s’applique généralement avec un fournisseur matériel de clichés instantanés disponible depuis une baie de stockage en réseau (SAN).

Une autre approche consiste à utiliser une partie des ressources disponibles au niveau du volume disque...

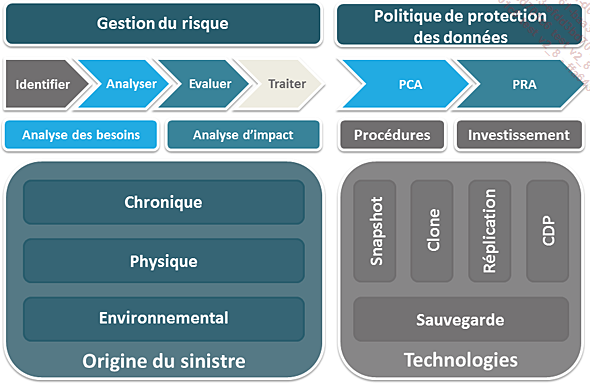

Choix des technologies en réponse aux sinistres

Toutes les technologies énoncées précédemment ont un rôle à jouer dans l’élaboration d’une politique de protection des données. La sauvegarde au même titre que la réplication, les clichés instantanés, les clones ou la CDP, sont des outils à part entière constituant les fondations techniques. Les autres technologies de protection de données énoncées doivent être utilisées systématiquement de manière complémentaire, afin de pallier les limitations techniques inhérentes à la sauvegarde, dans le but de répondre favorablement aux besoins de l’entreprise et aux exigences légales.

En aucun cas la sauvegarde ne peut être substituée par une quelconque autre technologie de protection de données, car elle constitue le dernier rempart en cas de sinistre.

1. Niveau de protection

Les différents niveaux de protection sont déterminés au moyen d’une échelle de valeur, définissant la « récupérabilité des données », en fonction d’un pondéré de différents critères, à savoir :

-

la qualité des données récupérables en cas de sinistre ;

-

la disponibilité de plusieurs versions possibles de la donnée ;

-

la fraîcheur des données (récentes ou non).

Ces critères sont établis sur la base des limites imposées, en termes d’utilisation, par chacune des technologies de protection de données.

|

Indice |

Échelle |

Restaurabilité des données |

|

-1 |

Non applicable |

Le sinistre n’a pas d’impact sur les données. Il n’y a donc pas de perte ou de corruption dans ce cas. |

|

0 |

Néant |

Les données perdues, corrompues ou altérées ne sont pas récupérables. |

|

1 |

Basique |

Les données sont récupérables sur la base de la fréquence de déclenchement de la technologie mentionnée. La perte de données peut être estimée à quelques heures dans certains cas mais est généralement supérieure à 8 heures. |

|

2 |

Bon |

La dernière... |

Déduplication des données

1. Une méthodologie révolutionnaire

En 1991, le brillant informaticien australien Ross Neil Williams obtient son doctorat en compression de données au sein de l’Université d’Adélaïde. En 1996, il dépose un brevet portant sur un système de partitionnement des données à longueur variable sous le numéro U.S. Patent 599081. Les fondements de la déduplication des données sont alors posés.

Quelques années plus tard, en 2001, Ross Neil Williams fonde Rocksoft Pty Ltd, une société proposant des services en matière de stockage et de contrôle d’intégrité des données. Le fondateur se lance alors dans la commercialisation de sa méthodologie de réduction de données. Cinq années de labeur lui seront alors nécessaires afin d’intégrer son approche dans une solution logicielle commercialisable.

En 2006, l’entreprise américaine ADIC, fabricant de robotique de bandes, fait l’acquisition de Rocksoft Pty Ltd avant d’être rachetée à son tour, dans le courant de la même année, par le géant américain Quantum Corporation. La déduplication connaît alors un essor considérable dans le domaine du stockage et de la protection des données. De nombreux éditeurs de logiciels de protection de données et fabricants de matériels de stockage informatique en ont désormais adopté les principes.

2. Les principes de la déduplication

La déduplication de données est une approche spécifique de réduction de données. Le fondement de la méthodologie employée vise à remplacer systématiquement chaque bloc identique, donc redondant, par un pointeur de référence vers un seul de ces blocs, et ce, dans un jeu de données. Par la suite, tout ensemble de blocs de données unique constitue ainsi un segment. Dans le cas précis de la sauvegarde ou encore de la réplication, le flux de données représente le jeu en question.

La déduplication des données a un double objectif. Elle augmente tout d’abord la quantité d’informations pouvant être stockées...

Editions ENI Livres | Vidéos | e-Formations

Editions ENI Livres | Vidéos | e-Formations