Une IA sur son poste de travail

Introduction

Alors que les solutions d’IA hébergées dans le cloud, telles que ChatGPT, Mistral AI, Llama ou bien encore Claude, ont démontré leur puissance et leur utilité, elles présentent certaines limitations significatives pour un usage professionnel au quotidien.

La dépendance à une connexion internet stable, les problèmes de confidentialité des données, leurs réutilisabilités à des fins d’entraînement ou bien encore la sensibilité de ces dernières transitant par des serveurs externes sont autant de freins à une adoption généralisée dans un contexte d’entreprise et cela s’entend !

Mais alors, comment sécuriser tout cela ? Pouvons-nous réellement faire confiance à notre IA générative préférée ? Tel pourrait d’ailleurs être l’intitulé de ce chapitre. Et si ce n’était pas le cas, quelles sont les alternatives qui peuvent s’offrir à chacun d’entre nous ? Nous allons tâcher d’y répondre par une solution consistant à disposer d’un LLM et de l’exécuter localement sur votre poste de travail. C’est une façon simple de s’assurer qu’aucune autre entreprise extérieure n’accédera à...

Identifier le LLM qui répond à vos besoins

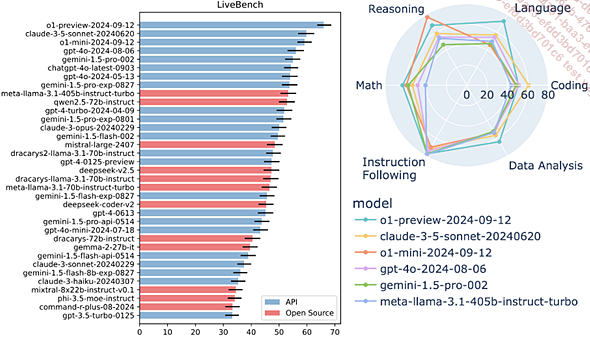

Le choix d’un modèle de langage adapté aux besoins d’une organisation technologique constitue une décision critique qui influencera durablement ses capacités d’innovation et d’efficacité opérationnelle.

Cette sélection ne doit pas reposer sur des critères subjectifs ou des tendances passagères, mais bien s’appuyer sur une analyse rigoureuse des caractéristiques techniques et fonctionnelles des différents LLM disponibles.

Quoi de mieux pour guider vos choix que des facteurs mesurés tels que la performance, l’accessibilité, l’alignement, la compréhension du langage naturel, le code informatique, l’analyse des données et la capacité à suivre des instructions.

C’est ce que propose merveilleusement bien le site LiveBench (https://livebench.ai/#/) qui nous offre, comme son nom l’indique, un Benchmark des différents modèles de langages disponibles pour choisir une solution en corrélation avec vos besoins sur les critères mentionnés précédemment.

À noter qu’à la date de rédaction de ce chapitre, la dernière analyse de performance des modèles de langage remonte au 30 septembre 2024.

Que constatons-nous sur ces grands ensembles ? Tout d’abord que les modèles tels que GPT « o1-preview-2024-09-12 », « claude-3-5-sonnet-20240620 » et « gpt-4o-2024-08-06 » se distinguent par leurs performances exceptionnelles sur les domaines clés.

Par exemple, « o1-preview-2024-09-12 » se positionne comme un leader, affichant des performances solides dans de nombreux domaines critiques pour l’IT, notamment le raisonnement et le suivi des consignes (instruction following).

1. LeaderBoard : le premier benchmark LLM au monde difficile à contourner

Poursuivons notre tour d’horizon et découvrons le « LeaderBoard » qui est une fonctionnalité...

Ollama

L’émergence d’Ollama (https://ollama.com/) marque un tournant décisif dans le domaine de l’intelligence artificielle et tout particulièrement pour les professionnels de l’IT. Cette solution révolutionnaire transforme la manière dont nous interagissons avec les modèles de langage (LLM), en proposant une approche que nous qualifierons de décentralisée et autonome.

Vous l’aurez compris, Ollama se distingue par sa capacité à exécuter des modèles de langage directement sur un poste de travail. Cette architecture locale présente un avantage majeur : l’indépendance totale vis-à-vis du cloud. L’application transforme votre ordinateur en un véritable centre d’intelligence artificielle personnel, capable de fonctionner sans connexion Internet. Il est entendu qu’une configuration adéquate est de mise pour bénéficier de performances dignes de ce nom.

Puisque Ollama fonctionne localement, les données restent confidentielles et ne sont pas envoyées à un service en ligne.

La gestion des grands modèles modèle de langage constitue l’un des points forts d’Ollama. Le système propose une bibliothèque de modèles pré-entraînés, soigneusement optimisés pour une utilisation locale. Les tailles varient...

Comment exécuter Ollama sur son poste de travail ?

Avant de commencer l’installation d’Ollama, il est essentiel de vérifier que votre environnement technique est prêt à accueillir votre nouveau compagnon d’IA.

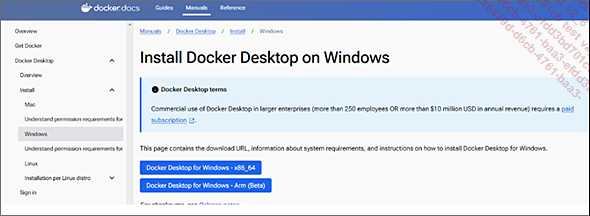

La première étape vers une installation réussie est d’installer Docker Desktop, qui vous sera indispensable pour exécuter des applications dites « conteneurisées ». Pour cela, vous devez disposer d’un système compatible avec Docker et avoir une bonne compréhension des principes de base de la conteneurisation et de l’architecture des systèmes. Cela vous permettra de tirer pleinement parti des fonctionnalités d’Ollama et d’assurer une installation en toute sécurité.

1. Étape 1 - Installation de Docker

Ollama peut être facilement installé sur différents systèmes d’exploitation tels que macOS et Linux, mais également sur Windows.

L’utilisation d’un conteneur Docker est recommandée pour une installation indépendante de votre machine. Les images Docker pour Ollama et Ollama Web-UI sont disponibles et les instructions d’installation complètes se trouvent sur les pages de dépôt et Docker Hub.

Si ce n’est pas déjà fait, vous pouvez installer Docker sur votre environnement de travail à partir des éléments ci-dessous.

Configuration requise pour l’installation de Docker sur votre poste Windows :

-

Windows 10 64-bits.

-

Activer la fonctionnalité WSL 2 on Windows. Ouvrez l’invite de commandes PowerShell ou Windows en mode administrateur en cliquant avec le bouton droit et en sélectionnant Exécuter en tant qu’administrateur, entrez la commande wsl --install, puis redémarrez votre machine.

-

Avoir un processeur 64-bits.

-

Avoir 4 Go de RAM minimum.

Rendez-vous tout d’abord sur le Docker Hub et téléchargez l’installateur pour Windows : https://docs.docker.com/desktop/install/windows-install/

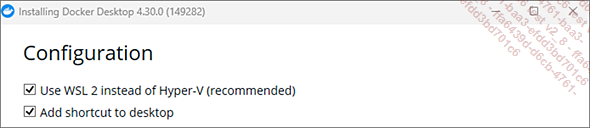

Double cliquez sur Docker Desktop Installer.exe pour lancer l’installation.

N’oubliez pas d’activer l’utilisation de WSL 2 pour Windows.

À la fin de l’installation, Docker vous demandera de redémarrer votre poste de travail....

Comment intégrer Ollama dans votre IDE ?

Intégrer Ollama à votre éditeur de code peut améliorer considérablement votre expérience de codage en fournissant une assistance IA directement dans votre espace de travail. Cela peut être réalisé grâce à l’extension Continue, disponible pour les éditeurs Visual Studio Code et JetBrains. Vous pouvez trouver l’extension sur le site https://continue.dev/.

En intégrant Ollama à votre éditeur de code, vous pouvez bénéficier d’une assistance IA personnalisée pour améliorer votre productivité et votre efficacité. L’extension Continue vous permet de connecter Ollama à votre éditeur de code et de profiter de fonctionnalités telles que l’autocomplétion de code, la référence et le chat, ainsi que la réécriture de code à partir du langage naturel. Téléchargez l’extension Continue dès aujourd’hui et découvrez comment Ollama peut améliorer votre expérience de codage !

Une fois l’extension installée, vous devez la configurer pour qu’elle fonctionne avec Ollama. Cela implique d’ajouter Ollama au fichier de configuration de l’extension.

Dans votre répertoire personnel, recherchez le dossier .continue...

Interroger un LLM en JavaScript avec Ollama

Dans cette section, nous allons explorer comment utiliser la bibliothèque JavaScript Ollama pour interroger un modèle de langage local et créer un chatbot simple.

Cette section est inspirée d’un super tutoriel du site Alsacreation : https://www.alsacreations.com/tuto/lire/1931-IA--Interroger-un-LLM-en-JavaScript-avec-Ollama.html

Étape 1 - Installer Ollama

Pour commencer, nous devons installer Ollama sur notre machine. Ollama est une application qui permet de télécharger et d’exécuter des modèles de langage localement. Nous pouvons l’installer en utilisant la commande suivante :

sh

npm install --save ollama Étape 2 - Télécharger un modèle de langage

Une fois Ollama installé, nous pouvons télécharger un modèle de langage. Pour cet exemple, nous allons utiliser le modèle llama3.2. Nous pouvons le télécharger en utilisant la commande suivante :

sh

ollama pull llama3.2 Étape 3 - Créer un script pour interroger le modèle

Maintenant que nous avons téléchargé le modèle, nous pouvons créer un script pour interroger le modèle. Nous allons créer un fichier chat.mjs avec le contenu suivant :

javascript

Copier

import ollama from 'ollama';

const response = await ollama.chat({

model: 'llama3.2',

messages: [{ role: 'user', content: 'Bonjour, comment allez-vous ?' }],

});

console.log(response.message.content); Nous...

Conclusion

Nous avons exploré les aspects pratiques de l’intégration d’une intelligence artificielle sur le poste de travail des développeurs. Notre analyse s’est concentrée sur trois axes majeurs qui permettent une adoption efficace de ces outils.

Tout d’abord, nous avons souligné l’importance cruciale du choix du LLM adapté aux besoins spécifiques. Cette sélection nécessite une évaluation minutieuse des paramètres techniques, des performances et des contraintes propres à chaque environnement de développement.

Nous avons ensuite détaillé la mise en œuvre d’Ollama, démontrant comment cette solution peut être déployée efficacement et très facilement sur un poste de travail. Cette approche locale offre des avantages significatifs en termes de confidentialité et de performance, tout en maintenant une grande flexibilité d’utilisation.

L’intégration d’Ollama dans l’IDE, dernier point abordé, représente une avancée majeure dans la façon dont les développeurs peuvent interagir avec l’IA au quotidien. Cette symbiose entre l’environnement de développement et l’intelligence artificielle ouvre la voie à une productivité accrue et une expérience de développement enrichie....

Editions ENI Livres | Vidéos | e-Formations

Editions ENI Livres | Vidéos | e-Formations